2020年11月16日,AMD发布全新架构计算卡Instinct MI100,AI性能暴涨7倍

芝麻汤圆

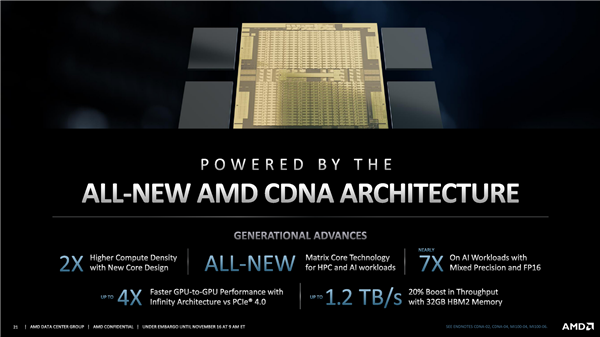

芝麻汤圆Instinct MI100 是其迄今为止性能最高的HPC GPU,FP64双精度浮点性能首次突破10TFlops(也就是每秒1亿亿次),并在架构设计上专门加入了Matrix Core(矩阵核心),用于加速HPC、AI运算,号称在混合精度和FP16半精度的AI负载上,性能提升接近7倍。

扩展阅读

Instinct MI100 集成多达120个计算单元、7680个流处理器,搭配32GB HBM2,带宽高达1.23TB/s,同时支持PCIe 4.0,集成Infinity Fabric x16高速互联通道,峰值带宽达276GB/s(相当于PCIe 4.0 x16的大约4倍),而整卡功耗控制在300W。

计算性能方面,FMA64/FP64双精度为11.5TFlops(每秒1.15亿亿次),FMA32/FP32单精度为23.1TFlops(每秒2.31亿亿次),FP32 Matrix单精度矩阵计算为46.1TFlops(每秒4.61亿亿次),FP16 Matrix半精度矩阵计算为184.6TFlops(每秒18.46亿亿次),Bfloat16浮点为92.3TFlops(每秒9.23亿亿次)。

如今的一块卡,就相当于20年前的一个大规模计算集群!

AMD上代计算卡Instinct MI50采用的还是Vega 20核心,60个计算单元,3840个流处理器,32GB HBM2显存带宽1TB/s,Infinity Fabric总线带宽92GB/s,功耗300W。

Instinct MI100的核心规模翻了一番,显存带宽提升了超过20%,Infinity Fabric带宽提升了整整2倍,但是功耗却完全没变(工艺应当也还是7nm),新架构的能效可见一斑。

新卡的性能更是不可同日而语,FP64双精度、FP32单精度性能均提升74%,FP32矩阵性能提升接近2.5倍,AI负载性能更是几乎7倍的飞跃。

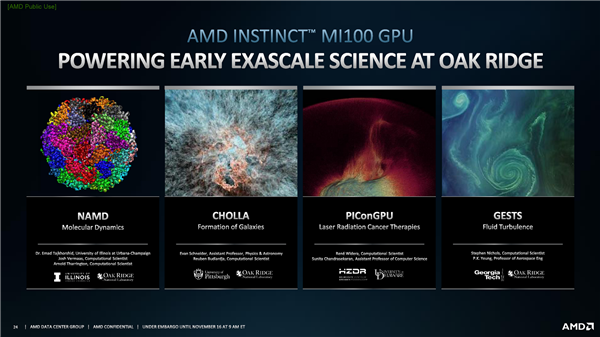

在美国能源部旗下的橡树岭国家实验室,AMD MI100计算卡已经在支撑多项百亿亿次科研项目,涉及NAMD分子动力学模拟、CHOLLA星系形成研究、PIConGPU激光放射癌症疗法、GESTS流体动力学等等诸多前沿科技。

AMD Instinct MI100计算卡还有一个绝佳搭档,那就是AMD自家的霄龙数据中心处理器,慧与、戴尔、超威、技嘉等多家行业巨头都有提供这种双A方案。

当然了,只有硬件,是做不成高性能计算的,AMD同时一直在推进一站式软件解决方案ROCm。

从2016年初入江湖的1.x版本,2018年奠定基础的2.0版本,到2019年专注于机器学习的3.0版本,再到如今最新的4.0版本,AMD ROCm已经打造成了一整套针对机器学习、高性能计算的百亿亿次级开发方案,规划中的各项功能特性也基本都已经实现。

软件优化的力量无疑是巨大的,可以充分释放硬件潜力,比如说上代MI50,搭配ROCm 3.0的话性能相比于搭配ROCm 2.0可以提升3-4倍,而最新的MI100、ROCm 4.0联合,更是可以轻松带来5-8倍的性能提升。AMD ROCm生态的进步速度非常快,已经有众多领域的头部厂商采纳和支持,而且它沿袭了AMD一贯的原则,那就是完全开源开放,非常方便代码迁移,比如说HACC(宇宙学)只用了一个下午,SPECFEM3D(地震学)半天就搞定,CHOLLA(天体物理学)花了几天,QUDA(量子物理学)也不过21天。

未知的网友